La lucha de Amazon por romper la hegemonía de Nvidia en chips de IA, contada desde dentro

Andrej Sokolow/Getty Images; F. Carter Smith/Bloomberg via Getty Images; Alyssa Powell/BI

- Los chips de IA de Amazon están muy por detrás de las GPU de Nvidia, con bajas tasas de adopción entre los grandes clientes de la nube.

- El dominio de Nvidia con su plataforma CUDA plantea importantes retos para los chips de IA de Amazon.

- Amazon está colaborando con la comunidad de código abierto para mejorar la adopción y la cuota de mercado de sus chips de IA.

Amazon está sufriendo para poder competir con los dominantes chips de IA de Nvidia, debido a su bajo uso, las "deficiencias de compatibilidad" y los problemas de migración de proyectos que ponen en riesgo millones de dólares en ingresos en la nube, según documentos internos confidenciales y personas familiarizadas directamente con el asunto.

Es otra señal de lo rezagado que está el gigante de la nube en la carrera de la IA generativa. Esto también demuestra lo difícil que será para las empresas tecnológicas como Microsoft, OpenAI, Google, Meta y Amazon romper el control de Nvidia en este enorme e importante mercado.

Stacy Rasgon, veterana analista de chips de la consultora Bernstein Research, afirma que todas las grandes empresas tecnológicas quieren hacerse con una parte del negocio de Nvidia, pero que ninguna ha sido capaz de hacerse un hueco.

"No conozco a nadie que utilice chips AWS en grandes volúmenes", explica Rasgon a Business Insider.

Plataformas de IA y rentabilidad de AWS

Amazon

Amazon Web Services es la empresa líder en la nube, y alquila capacidad de cálculo y almacenamiento a través de internet. Parte de su éxito, especialmente su rentabilidad, se basa en el diseño de sus propios chips para centros de datos, evitando tener que pagar a Intel por estos costosos componentes.

En la nueva era de la inteligencia artificial generativa, Amazon está tratando de repetir el éxito fabricando sus propios chips de inteligencia artificial, conocidos como Trainium e Inferentia. Esta vez, la idea es evitar tener que pagar las carísimas GPU de Nvidia, sin dejar de ofrecer a los clientes de la nube potentes servicios de IA.

Amazon lleva al menos cuatro años en este proceso y, de momento, Nvidia está demostrando ser un hueso duro de roer.

Nvidia lleva más de una década creando una plataforma llamada CUDA para facilitar a los desarrolladores el uso de sus unidades de procesamiento gráfico (las GPU). La industria se ha adaptado a ello. Ahora Amazon tiene que deshacer de algún modo todos esos hábitos y complejas interrelaciones técnicas.

Cuando Amazon se enfrentó a los chips de Intel en el primer boom de la nube, AWS fue la pionera, creando la plataforma que estableció estándares y procesos. Esta vez, es Nvidia quien tiene el liderazgo. Si Amazon no consigue abrir camino de forma significativa, podría verse obligado a pagar a Nvidia, y la rentabilidad de AWS podría resentirse.

"Puntos de fricción y adopción asfixiante"

La magnitud de este desafío se revela en los documentos internos de Amazon a los que ha tenido acceso BI y por las personas familiarizadas con los esfuerzos de la compañía en materia de chips de IA. Estas personas han pedido no ser identificadas al tratarse de asuntos privados sensibles. BI conoce sus identidades.

El año pasado, la tasa de adopción de los chips Trainium entre los principales clientes de AWS fue apenas un 0,5% de las GPU de Nvidia, según uno de los documentos internos. Esta evaluación, que mide los niveles de uso de diferentes chips de IA a través del servicio en la nube de AWS, se elaboró en abril.

Inferentia, un chip de AWS diseñado para un tipo de tarea de IA conocida como inferencia, obtuvo un resultado sólo ligeramente mejor, con un 2,7% de la tasa de uso de Nvidia.

El documento interno señala que los grandes clientes de la nube se han enfrentado a "dificultades para adoptar" los chips de IA personalizados de AWS, en parte debido al gran atractivo de la plataforma CUDA de Nvidia.

"Los primeros intentos por parte de los clientes han puesto de manifiesto puntos de fricción y han ahogado la adopción", decía el documento.

Esto contradice la visión más optimista que los ejecutivos de Amazon han compartido sobre los esfuerzos de AWS en chips de IA. En una conferencia sobre resultados celebrada en abril, el CEO Andy Jassy dijo que la demanda de silicio personalizado de AWS era "bastante alta", y en su carta anual a los accionistas de este año mencionó a algunos de los principales clientes, como Snap, Airbnb y Anthropic.

Incluso el ejemplo de Anthropic tiene un gran asterisco al lado. Amazon invirtió unos 4.000 millones de dólares en esta startup de IA, y parte de ese acuerdo exige que Anthropic utilice los chips de IA internos de AWS.

Las raíces del negocio de chips de Amazon

Amazon

El negocio de chips de Amazon empezó en serio cuando adquirió la startup Annapurna Labs en 2015 por unos 350 millones de dólares. Esto ayudó al gigante tecnológico a diseñar sus propios chips. Ahora ofrece unidades centrales de procesamiento Graviton basadas en arquitectura Arm para la mayoría de las tareas informáticas no relacionadas con la IA. Inferentia debutó en 2018, y Trainium salió por primera vez en 2020.

Otros gigantes tecnológicos, como Google y Microsoft, también están diseñando chips de IA personalizados. Al mismo tiempo, las tres principales empresas de la nube, AWS, Microsoft Azure y Google Cloud, figuran entre los mayores clientes de Nvidia, ya que venden acceso a esas GPU a través de sus propios servicios en la nube.

Los esfuerzos internos en el campo de los chips de IA aún no han hecho mella en el dominio de Nvidia sobre el mercado. El pasado miércoles, Nvidia informó de otro trimestre espectacular, triplicando con creces los ingresos de hace un año. El fabricante de chips está valorado en unos 2,5 billones de dólares. Es decir, al menos 500.000 millones más que Amazon. Según la empresa de investigación Omdia, Nvidia acapara ahora aproximadamente el 80% del mercado de chips de inteligencia artificial.

Un portavoz de AWS afirma que "los clientes están cada vez más entusiasmados" con el último chip Trainium, que usan Anthropic y Databricks para entrenar modelos de IA.

Los chips de IA de AWS son todavía relativamente nuevos, por lo que Amazon mide su éxito en función de su uso general y de los comentarios positivos de los clientes, que "están creciendo bien", más que por su cuota de cargas de trabajo, añade el portavoz.

La gran cantidad de capacidad de GPU que AWS ha acumulado en la última década contribuye a un "uso muy grande" de los chips de Nvidia, señala el portavoz.

"Estamos animados por el progreso que estamos haciendo con nuestros chips de IA personalizados", dicen en un comunicado. "La creación de un gran hardware es una inversión a largo plazo, y tenemos experiencia en ser persistentes y exitosos".

"Paridad con CUDA"

Internamente en Amazon, la plataforma CUDA de Nvidia se cita repetidamente como el mayor obstáculo para la iniciativa de chips de IA. Lanzada en 2006, CUDA es un ecosistema de herramientas de desarrollo, bibliotecas de IA y lenguajes de programación que facilita el uso de las GPU de Nvidia para proyectos de IA. La ventaja de CUDA ha proporcionado a Nvidia una plataforma increíblemente sólida, que muchos consideran el secreto del éxito de la compañía.

Amazon sólo espera una adopción modesta de sus chips de IA a menos que su propia plataforma de software, AWS Neuron, pueda alcanzar "una paridad mejorada con las capacidades de CUDA", dice uno de los documentos internos.

Neuron está diseñada para ayudar a los desarrolladores a construir más fácilmente sobre los chips de IA de AWS, pero la configuración actual "impide la migración desde NVIDIA CUDA", añade el documento.

Meta, Netflix y otras empresas han pedido que AWS Neuron empiece a soportar datos en paralelo totalmente fragmentados, un tipo de algoritmo de entrenamiento de datos para GPU. Sin ello, estas empresas "ni siquiera se plantearán" utilizar chips Trainium para sus necesidades de entrenamiento de IA, según este documento interno de Amazon.

La decisión de Snowflake sobre CUDA

Eóin Noonan/Getty Images

Snowflake, uno de los principales proveedores de datos en la nube, es una de las empresas que eligió las GPU de Nvidia en lugar de los chips de IA de Amazon para entrenar su propio modelo lingüístico de gran tamaño, Arctic. Y eso a pesar de que Snowflake es uno de los principales clientes de la nube de AWS.

El CEO de Snowflake, Sridhar Ramaswamy, explica a BI que la familiaridad con CUDA hacía difícil la transición a una GPU diferente, especialmente cuando al hacerlo se corría el riesgo de obtener resultados inesperados.

El entrenamiento de los modelos de IA es caro y requiere mucho tiempo, por lo que cualquier contratiempo puede generar retrasos de alto coste. Elegir lo que ya se conoce —CUDA, en este caso— es una decisión natural en estos momentos para muchos desarrolladores de IA.

Según Ramaswamy, la rentabilidad y el rendimiento avanzado de las GPU de Nvidia pueden estar "años" por delante de la competencia.

"Entrenamos Arctic en instancias Amazon EC2 P5 para que utilizaran chips de Nvidia porque lo habíamos arquitecturado en CUDA", explica a BI (EC2 P5 ofrece a los clientes de AWS acceso en la nube a las GPU Nvidia H100).

El portavoz de Amazon afirma a BI que AWS ofrece a los clientes de la nube "la opción y flexibilidad de utilizar lo que mejor les convenga", en lugar de obligarles a cambiar.

La temprana inversión de Nvidia en CUDA la convierte en una "herramienta esencial" para desarrollar con GPU, pero está "centrada exclusivamente en el hardware de Nvidia", añade el portavoz de Amazon. El objetivo de AWS con Neuron no es necesariamente alcanzar la paridad con CUDA, añade.

AWS puede seguir generando ingresos cuando los clientes utilicen sus servicios en la nube para tareas de IA, incluso si eligen las opciones de GPU de Nvidia en lugar de Trainium e Inferentia. Sólo que esto podría ser menos rentable para AWS.

Fracaso en la sustitución de las GPU

La demanda explosiva de chips Nvidia también está causando una escasez de GPU en Amazon, según uno de los documentos internos y las personas familiarizadas con el asunto.

Una respuesta lógica a este problema sería que los clientes de la nube utilizaran los chips de IA de Amazon en su lugar. Sin embargo, algunos de los mayores clientes de AWS no han estado dispuestos a utilizar estas alternativas de producción propia, según los documentos.

Según este documento, algunos clientes han comunicado a Amazon que los chips de Inferentia están por detrás en rendimiento y eficiencia de costes de las GPU de Nvidia, y sus problemas de rendimiento se han escalado internamente.

La imposibilidad de sustituir la demanda de GPU Nvidia de los clientes por la de las ofertas de AWS ha provocado retrasos en los servicios y ha puesto en peligro millones de dólares en ingresos potenciales, según el documento.

Según este documento, AWS analizó la posibilidad de dividir las cargas de trabajo entre diferentes regiones y establecer bloques de capacidad de GPU Nvidia más flexibles y de mayor precio para paliar el problema de escasez.

Amazon incluso utiliza las GPU de Nvidia para sus propios proyectos

Amazon

Incluso algunos de los proyectos internos de IA de Amazon utilizan GPU de Nvidia, en lugar de los chips propios de AWS.

A principios de este año, el equipo de retail de Amazon utilizó un clúster de GPUs Nvidia, incluyendo V100s, A10s y A100s, para construir un modelo para una nueva herramienta de creación de imágenes de IA, según muestra otro documento interno. No se mencionaban los chips de AWS.

En enero, James Hamilton, vicepresidente senior e ingeniero destacado de Amazon, hizo una presentación sobre aprendizaje automático y dijo que uno de sus proyectos utilizaba 13.760 GPU Nvidia A100.

No está claro el rendimiento financiero de los chips de IA de AWS, ya que Amazon no desglosa las ventas específicas de cada segmento de la nube. Pero en abril, Jassy reveló que su gama de productos de IA estaba en camino de generar ingresos multimillonarios este año. Eso es importante para AWS, ya que su tasa de crecimiento se ha estancado en los últimos años, aunque se recuperó en los últimos trimestres.

Amazon está siguiendo una estrategia de ventas que consiste en poner a disposición una variedad de chips de IA a través de su servicio en la nube. Según una directriz de ventas interna vista por BI, se anima a los comerciales de Amazon a mencionar el acceso tanto a las GPU de gama alta de Nvidia como a los chips más asequibles de AWS a la hora de vender servicios de computación de IA.

Una persona familiarizada con el asunto explica a BI que Amazon considera que existe una oportunidad suficientemente grande en el mercado de gama baja, aunque eso signifique ceder clientes de gama alta a Nvidia por el momento.

Prioridad al código abierto

Según la empresa de investigación Gartner, se prevé que el mercado de chips de IA se duplique con creces hasta alcanzar los 140.000 millones de dólares en 2027.

Para conseguir una mayor cuota de mercado, Amazon quiere trabajar más estrechamente con la comunidad de código abierto, según uno de los documentos internos obtenidos por BI.

Por ejemplo, los chips de IA de AWS todavía tienen "lagunas de compatibilidad" en ciertos marcos de código abierto, lo que hace que las GPU de Nvidia sean una opción más popular. Al adoptar tecnologías de código abierto, AWS puede construir una "experiencia diferenciada", dice.

Como parte de este esfuerzo, Amazon está dando prioridad al soporte de modelos de código abierto como Llama y Stable Diffusion, según uno de los implicados.

El portavoz de Amazon indica que AWS se ha asociado con Hugging Face, un polo de modelos de IA, y que es miembro fundador de una iniciativa de aprendizaje automático de código abierto llamada OpenXLA para facilitar a la comunidad de código abierto el aprovechamiento de los chips de IA de AWS.

No hay que descartar a Amazon

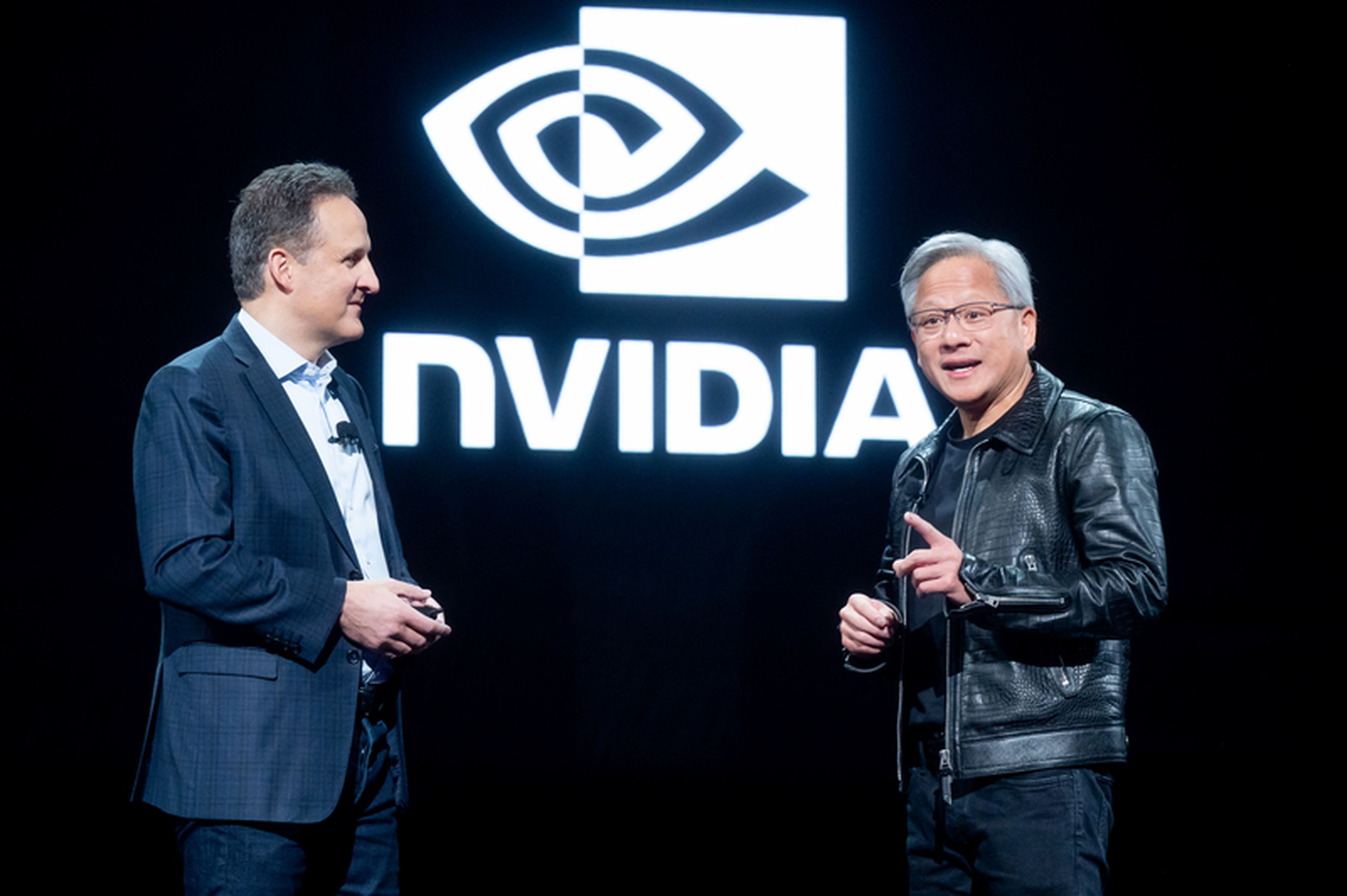

A pesar de las dificultades de Amazon con los chips de IA, el esfuerzo parece haber llamado la atención del CEO de Nvidia, Jensen Huang.

Durante una entrevista a principios de este año, Huang fue preguntado sobre el entorno competitivo de Nvidia.

"No solo tenemos competencia de los competidores, tenemos competencia de nuestros clientes", dijo Huang, refiriéndose a gigantes de la nube como AWS que venden acceso tanto a las GPU de Nvidia como a sus propios chips. "Y yo soy el único competidor de un cliente a sabiendas de que está a punto de diseñar un chip que sustituya al nuestro".

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.